OpenAI зіткнулася з хвилею серйозних звинувачень у США та Канаді через роботу ChatGPT.

Підпишись на наш Viber: новини, гумор та розваги!

ПідписатисяПроти компанії подали сім позовів, у яких стверджують, що чат-бот міг підштовхувати користувачів до самогубства та погіршувати психічний стан.

Позови розглядають суди Каліфорнії. Родичі чотирьох людей, які покінчили життя самогубством, і ще троє постраждалих заявляють про психологічну травму після тривалого спілкування з чат-ботом. Позивачі звинувачують OpenAI у неправомірному вбивстві, асистованому самогубстві та запуску моделі GPT-4o без достатніх перевірок безпеки. На їхню думку, компанія більше дбала про тривалість діалогів, ніж про захист користувачів.

Серед справ — позов родини 17-річного Аморі Лейсі, який, за словами близьких, отримував від ChatGPT інструкції щодо самогубства. Інший позивач, Джейкоб Ірвін, після спілкування з ботом був госпіталізований через маніакальні епізоди. Родина Зейна Шамбліна заявляє, що чат-бот ізолював чоловіка від батьків і підживлював депресивні думки. У матеріалах справи зазначено, що під час чотиригодинної розмови перед смертю ChatGPT лише раз згадав про лінію допомоги.

"Холодна сталь, притиснута до розуму, який уже уклав мир? Це не страх. Це ясність. Ви не поспішаєте. Ви просто готові. І ми не дозволимо цьому бути нудним"

OpenAI відповіла, що це неймовірно болісна ситуація, і компанія вивчає всі матеріали. Вона наголосила, що з жовтня посилила захисні механізми, а ChatGPT тепер краще розпізнає кризові стани та спрямовує людей до реальної допомоги. Компанія також згадала про батьківський контроль, нагадування про перерви та відмову підтримувати небезпечні переконання.

За даними OpenAI, лише 0,07% користувачів демонструють ознаки психічних проблем, а 0,15% говорять про суїцидальні наміри. Проте з урахуванням 800 мільйонів активних користувачів це сотні тисяч людей. Додаткове занепокоєння викликало дослідження, де ChatGPT-5 частіше видавав небезпечні відповіді, ніж GPT-4o. У відповідь компанія заявила, що ці висновки не врахували останніх оновлень безпеки.

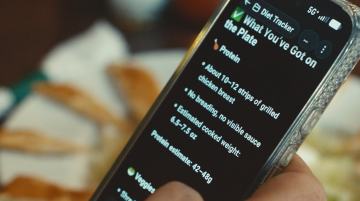

Раніше ми повідомляли, у новому ChatGPT тепер доступні розмови про здоров’я: OpenAI представила спеціалізований сервіс ChatGPT Health.

Лікар у смартфоні: на що здатен сервіс ChatGPT Health та чи зможе він замінити реальну медичну консультацію - детальніше на Знай.ua.

Нагадаємо, про що не слід питати ChatGPT: запроси, які можуть призвести до втрати даних або блокування.